自社AI(ローカルLLM)導入・運用サービス

ローカルLLMの安全性と安心運用

中小企業にとってAI導入で最も懸念されるのは「情報漏洩」や「外部依存のリスク」です。ローカルLLMを導入することで、外部クラウドに頼らず、自社サーバー内でデータを完結させることが可能になります。これにより、機密情報を安全に活用しつつ、生産性を高められます。本項目では、データセキュリティ、法令遵守、業界別リスク対策について詳しく解説し、安心してLLMを活用できる環境づくりをご提案します。

自社特化学習の重要性

汎用的なAIでは、各社独自の業務文脈や専門用語に対応できず、誤った回答や曖昧な提案になりがちです。自社の規程、マニュアル、過去のナレッジを学習させることで、初めて「自社専用の相談役」として機能するようになります。本項目では、自社特化学習の導入メリットや導入事例、データ準備の進め方などを整理し、限られた投資で大きな成果を生み出す仕組みを解説します。

RAG(検索拡張生成)による最新情報活用

RAG(Retrieval Augmented Generation)は、外部文書や社内データベースから必要な情報を取り出し、それをAIに組み込んで回答を生成する仕組みです。これにより、膨大な文書の中から最新かつ正確な回答を瞬時に提示できます。本項目では、RAGの仕組み、適用シーン(規程検索・商品情報回答・顧客対応)、導入のステップ、効果的なデータ準備方法についてわかりやすく解説します。

ファインチューニング手法とその活用

RAGと並ぶ強力な方法が「ファインチューニング」です。これはベースとなるLLMを、自社の専門データで再訓練し、AIの基本性能そのものを高める手法です。業界特有の応答品質を担保できる一方で、コストやデータ量の見積りが重要です。本項目では、ファインチューニングの種類(フル、LoRA、QLoRA)、導入判断の基準、中小企業でも実現可能なスモールスタート手法を詳しく紹介します。

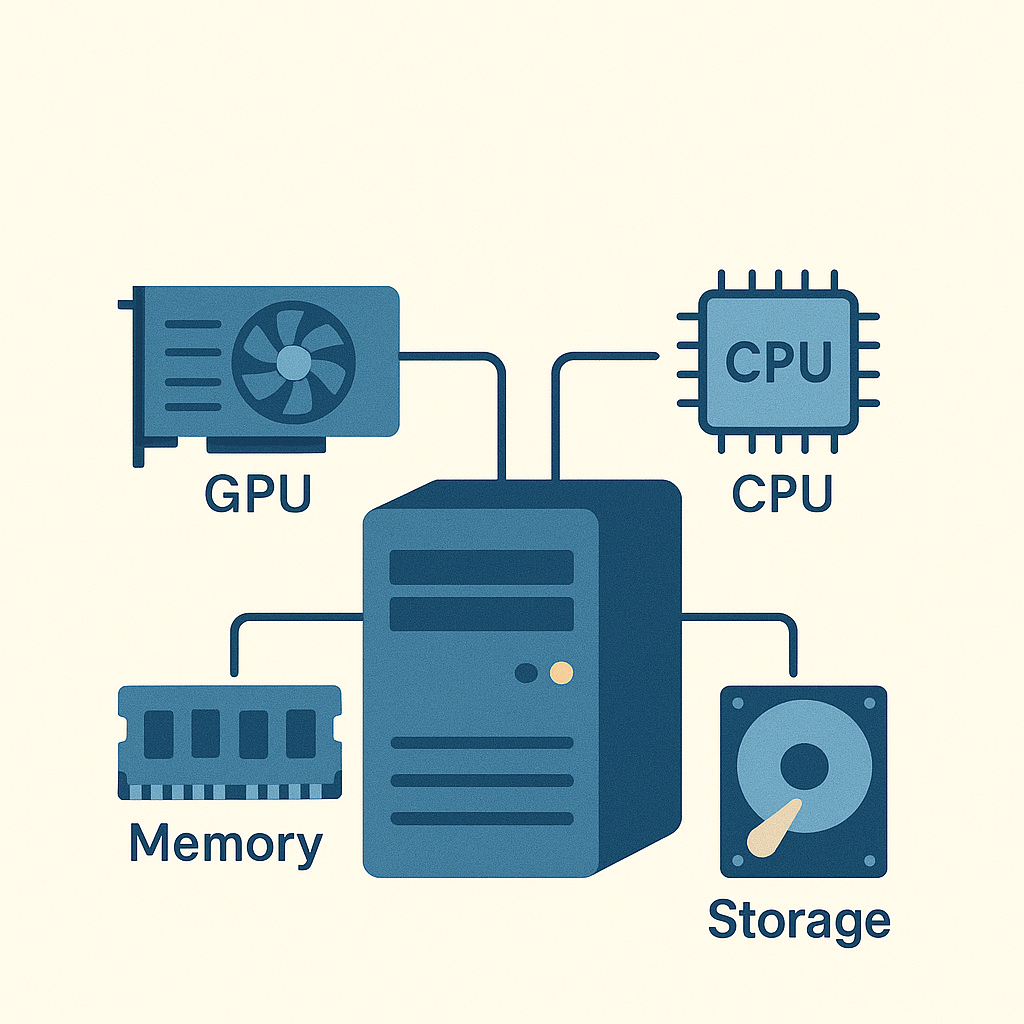

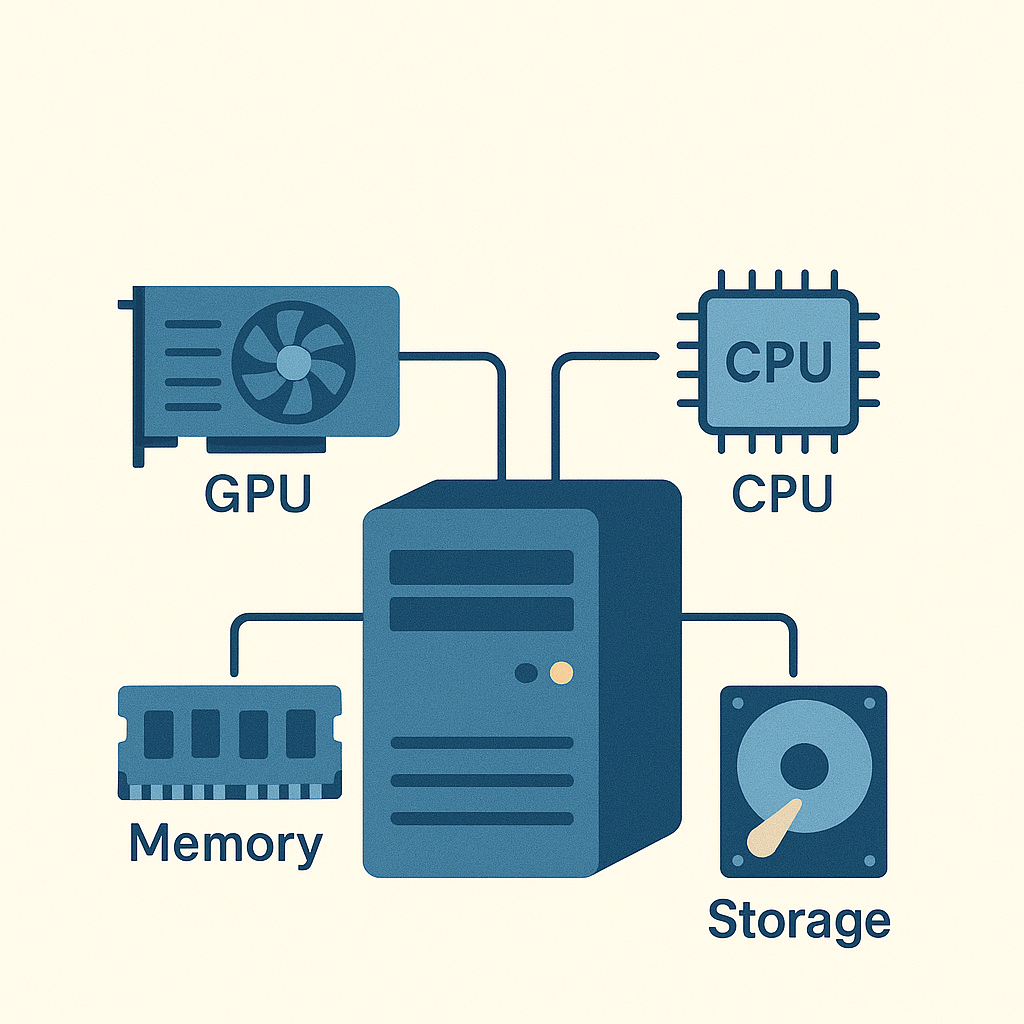

必要なハードウェアと運用設計

ローカルLLMの運用にあたり、最も現実的な課題が「ハードウェア要件」です。GPU性能やメモリ容量、電力消費などを適切に設計することで、コストと性能の最適バランスを確保できます。本項目では、中小企業でも導入しやすい構成例(RTXクラスGPU+ワークステーション)から、本格的サーバー環境まで、予算に応じた推奨環境と導入手順をわかりやすく整理します。

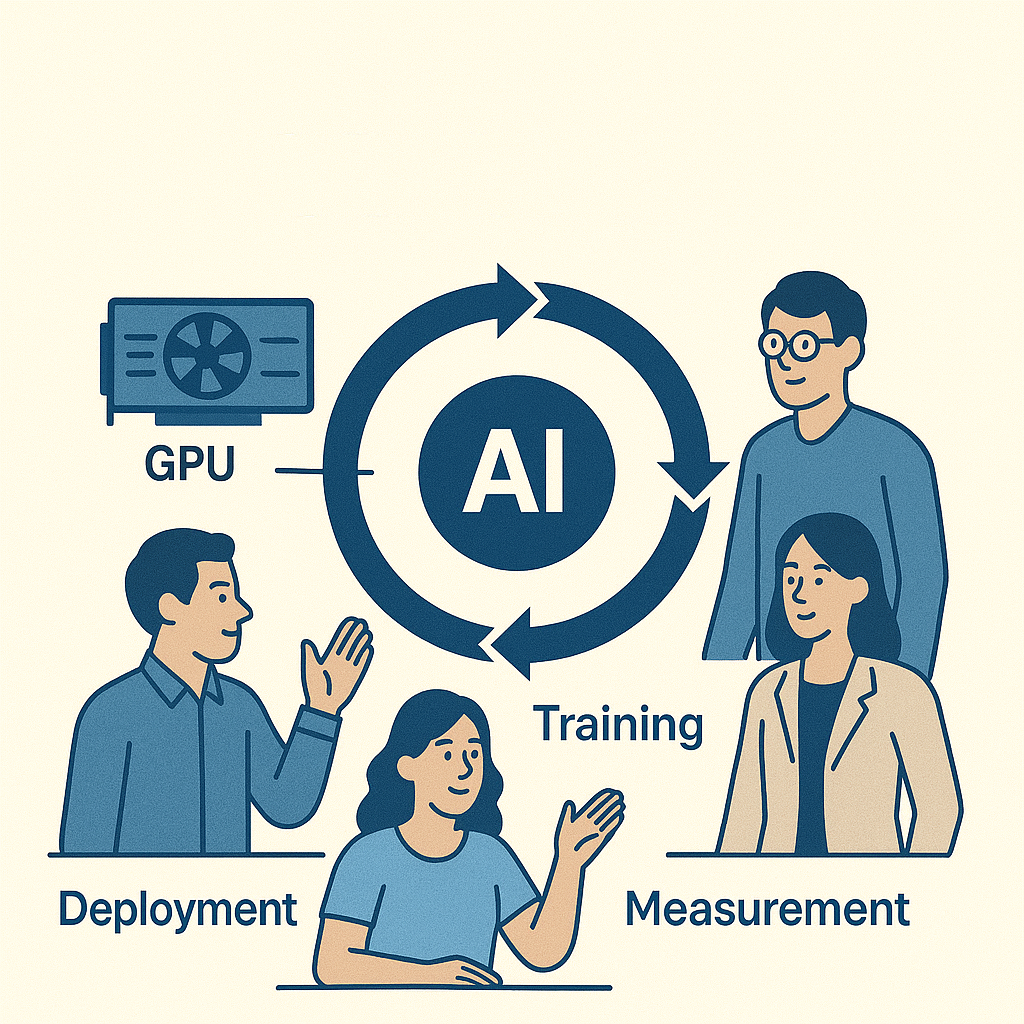

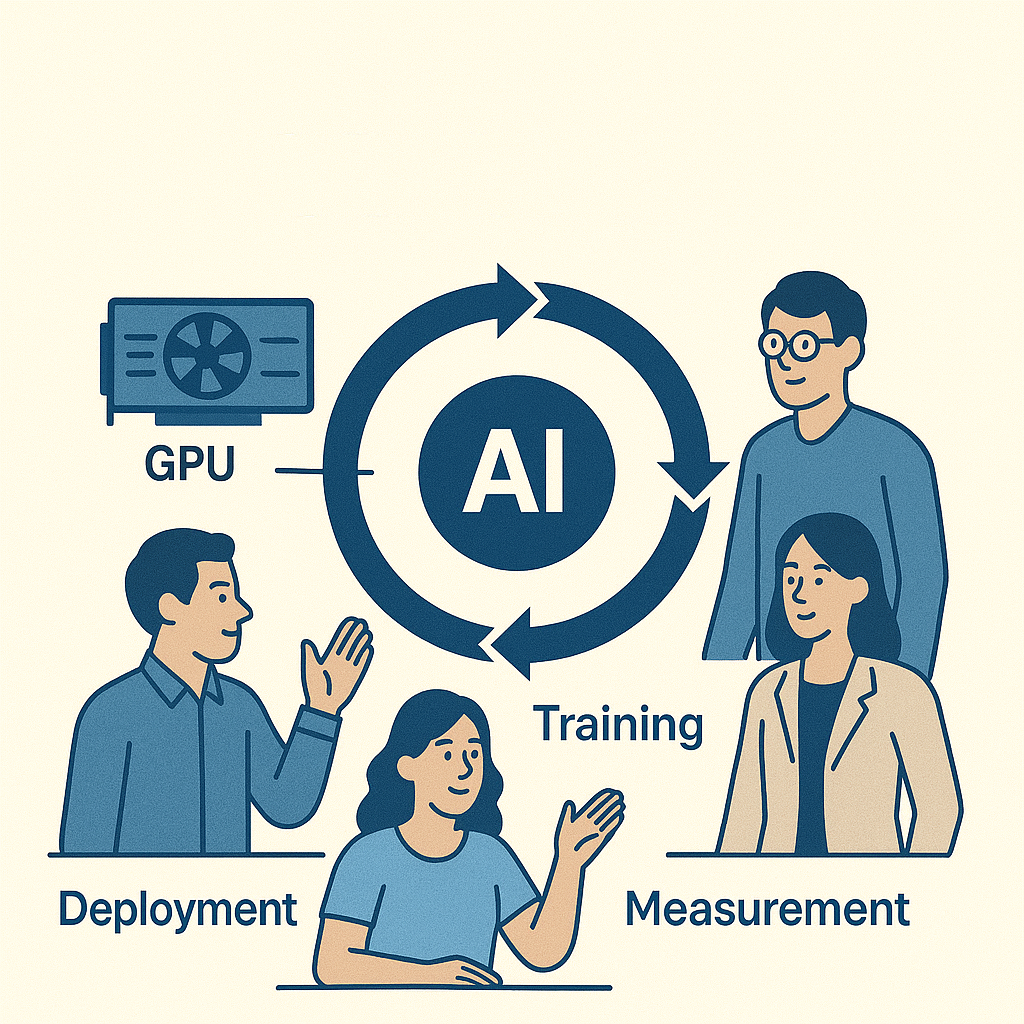

導入・運用サポートと導入後の価値最大化

AIは「導入して終わり」ではなく、運用と改善を繰り返すことで初めて成果が出ます。当サービスでは、初期設計からデータ整理、学習、運用サポートまでワンストップで提供します。さらに、導入後も継続的に効果測定を行い、業務フロー改善や追加学習を支援。中小企業がAIを“業務の一部”として根付かせるための総合的パートナーシップをご提案します。

① ローカルLLMの安全性と安心運用

企業がAIを導入する際、最も大きな懸念のひとつが「情報漏洩」や「データの外部流出」です。特に中小・中堅企業では、取引先リスト、顧客データ、設計図やノウハウといった重要情報をどのように安全に扱うかが、事業の存続に直結します。近年はクラウド型のAIサービスが広く普及していますが、外部サーバーに情報を預けることに抵抗を感じる企業は少なくありません。ローカルLLM(Large Language Model)を自社内に設置して運用する仕組みは、こうした課題を根本から解決する有効な手段となります。

ローカルLLMの最大の特徴は、「データが社外に出ない」ことです。社内サーバーやオンプレミス環境にモデルを設置することで、社員が利用する際の入力データや学習に利用するファイルは、すべて社内ネットワーク内で完結します。これにより、万一クラウドサービスが情報を再利用したり、外部からのアクセスが不正に行われたりするリスクを大幅に低減できます。特に、顧客情報や設計データなどの守秘性が高いデータを扱う企業にとっては、大きな安心材料です。

また、法令遵守の観点でもローカルLLMは有利です。近年は個人情報保護法やGDPRなど、国内外でデータ保護規制が強化されており、違反すれば高額な罰金や取引停止といったリスクが生じます。外部クラウドにデータを預ける場合、その提供先がどの国にサーバーを置いているか、どのような管理体制で運用しているかを把握しきれないケースがあります。ローカル運用であれば、データの所在が明確であり、社内のセキュリティポリシーに則した管理が可能になります。

さらに、業界ごとのリスク対策にも柔軟に対応できます。例えば、建設業や製造業では現場情報や施工データの扱いに厳しい規定がある場合があります。金融業界では、顧客口座情報や取引データの流出が信頼失墜に直結します。医療業界では、患者情報の扱いは厳格に規制されています。ローカルLLMであれば、これらの業界固有の要件に合わせたセキュリティ設定が可能であり、内部統制や監査対応もスムーズに行えます。

セキュリティの強化に加えて、ローカルLLMには「応答の透明性」を高める効果もあります。外部クラウド型AIでは、サービス提供側が裏で学習やチューニングを行っているため、ユーザー側にはブラックボックス化してしまうことが多くあります。一方でローカル運用であれば、学習に使ったデータの範囲や更新の履歴を明確に管理できるため、「どの情報を元に回答しているのか」を把握できます。これにより、経営層や情報システム部門が安心してAIを社内に展開できます。

もちろん、ローカル運用にはハードウェア投資や運用コストが必要です。しかし、クラウド利用で発生する「従量課金によるランニングコスト」や「利用規模の増加に伴う予測困難な請求額」と比較すると、初期投資を抑えながら安定した運用が可能になるケースも多くあります。特に中小企業では、社内の基幹システムやデータベースを活用するAI用途が中心となるため、比較的小規模なGPUサーバーでも十分な性能を発揮します。

まとめると、ローカルLLMの導入は単なる「セキュリティ強化」にとどまらず、法令遵守、業界特化対応、透明性向上、コスト予測性といった多面的なメリットをもたらします。中小・中堅企業にとっては、外部に依存せず「自社の情報を守りながら、自社のためにAIを育てていく」という安心感こそが最大の価値となります。当サービスでは、こうしたローカル環境構築から、最適なハードウェア設計、セキュリティ運用ルールの策定まで、一貫してご支援いたします。

② 自社特化学習の重要性

AIを業務に導入する際、最も大きな課題のひとつは「汎用AIでは自社業務に十分対応できない」という点です。一般的な大規模言語モデル(LLM)は、膨大な公開データや一般的な文章を学習しており、幅広い知識を持っています。しかし、その知識はあくまで「平均的・一般的な情報」に基づいたものであり、各企業が抱える専門的な業務内容や独自の用語、固有の業務フローには必ずしも対応できません。そこで重要になるのが「自社特化学習」です。

自社特化学習とは、LLMに対して自社独自のデータを追加で学習させることで、より業務に即した回答や提案ができるようにする仕組みです。例えば、建設会社であれば施工管理マニュアルや過去の現場報告書、製造業であれば工程表や検査基準書、商社であれば取引契約書や製品仕様書などを学習させることで、AIがその企業ならではの知識を持った“専用アシスタント”に変わります。

特化学習の効果はさまざまな場面で発揮されます。新人教育の場面では、過去の社内Q&Aやマニュアルを学習したAIが、新人の質問に即答し、教育コストを削減します。営業現場では、顧客の過去取引履歴や製品特性を理解したAIが提案資料を自動生成し、成約率を高めます。カスタマーサポートでは、製品マニュアルやトラブルシューティング事例を学習したAIが顧客対応を補助し、対応スピードを大幅に向上させます。このように、自社データを学習したAIは単なる「便利なツール」を超え、「自社専属のナレッジベース」として機能するのです。

特に中小・中堅企業では、業務が属人化しやすいという課題があります。特定の社員だけがノウハウを持っており、その人が不在になると業務が滞る、といったケースは少なくありません。自社特化学習を行うことで、暗黙知を形式知化し、AIを通じて組織全体に共有できます。これにより、業務の平準化や人材育成の効率化が可能となり、企業の競争力を高めることにつながります。

自社特化学習を進めるうえで重要なのは、学習に用いるデータの整理です。日々の業務で作成される文書や報告書は膨大で、フォーマットも統一されていないことが多くあります。そのままではAIに効率的に学習させられません。そのため、まずは「どのデータを学習させるべきか」を選定し、分類・整理するプロセスが必要です。当サービスでは、既存文書の整理から学習用データの形式変換までを支援し、企業が最小限の負担で特化学習を開始できる仕組みを整えています。

また、特化学習は「一度きり」では終わりません。企業は常に変化し、新しい規程や製品、取引先情報が追加されます。そのため、定期的にデータを更新し、AIに再学習させることで、常に最新の知識を持った状態を維持することが重要です。これを継続的に行うことで、AIはまさに「自社と共に成長するパートナー」となります。

導入コストの面でも、自社特化学習は有効です。大規模なファインチューニングを行わずとも、RAG(検索拡張生成)を活用することで比較的少ないコストで自社知識を取り込むことができます。さらに必要に応じて部分的なファインチューニングを組み合わせれば、より高精度かつ効率的に自社仕様のAIを育てられます。特に中小企業では「小さく始めて成果を見ながら拡張する」方式が適しており、リスクを抑えながら導入効果を実感できます。

まとめると、自社特化学習は「AIを自社に最適化するプロセス」であり、業務効率化・属人化解消・教育コスト削減・顧客満足度向上といった多面的な効果をもたらします。汎用AIでは実現できない「自社ならではの強み」を最大限に引き出すために不可欠な取り組みです。当サービスでは、データ整理から学習設計、運用更新までをワンストップで支援し、企業が無理なく「自社特化AI」を構築できる環境をご提供します。

③ RAG(検索拡張生成)による最新情報活用

AIを業務に導入する際、多くの企業が直面する課題が「最新情報を正確に反映できない」という点です。通常の大規模言語モデル(LLM)は、過去の学習データに基づいて応答を生成します。そのため、学習以降に発生した出来事や規程改定、最新の商品仕様などは反映できず、誤った回答や不十分な情報を提示するリスクがあります。こうした課題を解決する技術が「RAG(Retrieval Augmented Generation、検索拡張生成)」です。

RAGの仕組みはシンプルでありながら強力です。AIが回答を生成する際、事前に社内の文書データベースや外部の公開情報から関連性の高い情報を検索し、その内容を組み込んで回答を行います。これにより、従来の「固定された知識ベース」ではなく、「常に最新のデータを参照しながら回答する」仕組みが可能になります。言い換えれば、RAGはAIに「記憶」だけでなく「調べる力」を与える技術なのです。

この特徴は、中小・中堅企業の業務において大きなメリットをもたらします。例えば建設業では、現場ごとに仕様や規則が変わることが多く、最新版のマニュアルや施工基準を参照しなければ正確な判断ができません。RAGを導入すれば、社員がAIに質問した際、最新の施工マニュアルや社内規定が自動的に検索・参照され、誤解のない回答を得られます。製造業では、新しい製品の仕様書や検査基準が次々と追加されますが、それらをRAGで組み込めば、製造ラインの現場でも最新情報に基づいた判断を支援できます。商社やサービス業では、顧客ごとの契約条件や最新の価格表を参照した提案が可能になり、顧客対応の精度とスピードを大幅に高められます。

RAGの導入には、データの準備が欠かせません。まずは「検索対象となるデータ」を整備する必要があります。これには社内規程、マニュアル、製品カタログ、過去の顧客対応記録などが含まれます。これらを一定の粒度で分割(チャンク化)し、ベクトルデータベースに格納します。AIは質問を受けると、その質問を数値ベクトルに変換し、データベース内から最も関連性の高い文書を取り出します。その結果を組み合わせて回答を生成するため、従来よりも正確性と一貫性が大きく向上します。

重要なのは、RAGが「柔軟に更新できる」点です。LLMのファインチューニングでは、一度学習した内容を更新するには再学習が必要となり、時間やコストがかかります。一方でRAGでは、新しい規程やマニュアルをベクトルデータベースに追加するだけでAIがすぐに利用可能となります。この即時性は、変化の速い現代のビジネス環境において極めて有効です。法令改正、製品改良、取引条件の変更など、刻々と変わる情報をスムーズに反映できます。

さらにRAGは、企業のナレッジマネジメントの観点からも有効です。多くの中小企業では、膨大な社内資料がファイルサーバーやメールに分散しており、必要な情報を探すのに時間がかかります。RAGを導入すれば、「社員が質問するだけで必要な情報がすぐに返ってくる」という仕組みを構築でき、検索時間を削減し、業務効率を大幅に向上させます。また、従業員ごとに異なる検索スキルの差を吸収できるため、誰でも同じ水準で情報活用が可能になります。

コスト面でも、RAGは中小企業に適しています。大規模なモデル再学習を行わずとも、既存のLLMを活用しつつ、必要な情報を後付けで参照させることができるため、導入負担を大幅に軽減できます。小規模なサーバーやクラウド環境でも実現可能であり、「小さく始めて効果を確認し、徐々に拡張する」というアプローチが可能です。

まとめると、RAGはAIを「静的な知識ベース」から「動的で常に最新のアシスタント」へと進化させる技術です。中小・中堅企業にとって、変化に柔軟に対応し、業務効率を飛躍的に高める鍵となります。当サービスでは、データの選定・整理からベクトルデータベースの構築、RAG対応のLLMセットアップまで一貫して支援し、企業が安心して最新情報を業務に活用できる環境を提供します。

④ ファインチューニング手法とその活用

AIを企業に導入する際、RAGのように外部知識を参照させる方法は非常に効果的ですが、それだけでは十分に対応できない場面もあります。特に、企業固有の言い回しや業界特有の文脈に深く根差した知識を反映させたい場合、AIそのものの「基盤的な能力」を調整する必要があります。そこで重要になるのが「ファインチューニング(追加学習)」です。ファインチューニングとは、既存の大規模言語モデル(LLM)に対し、自社のデータを用いて再訓練し、応答の品質を高める手法を指します。

ファインチューニングの最大の特徴は、モデルが「自社の言語に馴染む」ことです。例えば、建設業の現場では「躯体」「型枠」「スラブ」といった専門用語が日常的に使われます。汎用AIはこれらの意味をある程度理解していても、現場で使われるニュアンスや使い分けまでは把握していません。しかし、自社の施工報告やマニュアルを用いてファインチューニングを行えば、AIが現場の言葉を正確に理解し、適切な文脈で返答できるようになります。同様に、製造業では工程名や検査基準、金融業では契約条項や金融商品名など、業界特有の知識を深く反映させられます。

ファインチューニングにはいくつかの手法があります。代表的なのが「フルファインチューニング」「LoRA」「QLoRA」です。フルファインチューニングはモデル全体を再学習する方法で、最も精度が高い反面、大量のデータと計算資源が必要になります。これに対してLoRA(Low-Rank Adaptation)は、モデルの一部のパラメータだけを調整する方法で、少ないデータと計算資源で済むため、中小企業にも現実的です。さらにQLoRAは、量子化技術を組み合わせて効率を最大化した方法で、GPUメモリを節約しながら大規模モデルを扱える点が特長です。こうした手法を適切に選択することで、限られたリソースでも実用的なカスタムAIを構築できます。

導入の際に重要なのは「どの範囲でファインチューニングするか」を明確にすることです。全社的に利用するナレッジベースとして汎用的な精度を上げたいのか、それとも特定部門(営業、技術、管理)に最適化したAIを作りたいのかによって、必要なデータ量や投資規模は大きく変わります。例えば、営業部門向けであれば過去の提案書やFAQを中心に学習させ、提案力を強化することが考えられます。技術部門向けであれば、設計資料や不具合事例を学習させることで、技術的な回答精度を高められます。このように、部門ごとにスモールスタートし、段階的に全社展開するアプローチが中小企業に適しています。

ファインチューニングの効果は、RAGとの組み合わせでさらに高まります。RAGが「最新情報を検索して回答する」仕組みであるのに対し、ファインチューニングは「AIの基礎能力を調整する」役割を持っています。例えば、契約書の特定条項について質問があった場合、RAGだけでは「条項本文を抜き出して提示する」にとどまります。しかしファインチューニングされたAIであれば、その条項の意味や過去の適用事例を理解し、分かりやすく説明できるようになります。つまり、RAGは情報の正確性を担保し、ファインチューニングは回答の深みと自然さを担保する関係にあるのです。

中小・中堅企業にとって、ファインチューニングを導入する最大のメリットは「少ないデータでも成果が出せる」点です。かつては数百万件規模のデータが必要とされましたが、LoRAやQLoRAを活用すれば、数千件~数万件のデータでも十分効果が得られます。例えば、過去5年分の社内マニュアルやFAQ、顧客対応ログを整理するだけでも、自社向けAIとして実用レベルの性能を引き出せます。また、初期投資を抑えながらも成果が見込めるため、「試しに導入してみる」ことが容易になりました。

もちろん、ファインチューニングには課題もあります。学習用データの質が低ければ、AIの回答も誤りや偏りを含みやすくなります。そのため、データの選別・前処理が極めて重要です。当サービスでは、学習に最適なデータを選定し、形式変換や品質チェックを行った上で効率的に学習を進める体制を整えています。さらに、導入後も定期的に学習データを追加し、モデルをアップデートすることで、企業の変化に追従できるようサポートします。

まとめると、ファインチューニングは「AIを自社専用に進化させるための中核技術」であり、業務効率化や属人化解消、顧客対応力強化に直結する施策です。RAGとの併用で効果を最大化できるため、中小・中堅企業にとっては極めて実用的なアプローチと言えます。当サービスでは、企業の規模や目的に応じて最適なファインチューニング手法を選定し、無理のない投資で成果を実感できる仕組みを提供します。

⑤ 必要なハードウェアと運用設計

ローカルLLMを自社で運用する際、最も現実的な課題のひとつが「どのようなハードウェアを準備すればよいのか」という点です。クラウド型サービスを利用する場合はインフラの心配は不要ですが、その代わりに利用料が従量課金となり、長期的にはコストが膨らむことがあります。一方、ローカル設営の場合は初期投資が必要になりますが、自社の利用状況に合わせて最適化でき、安定したコスト構造を築けるのが大きなメリットです。本項目では、中小・中堅企業が現実的に導入できるハードウェア構成と、運用設計の考え方を整理します。

まず、LLMを運用するうえで最も重要なのはGPU(グラフィックス処理装置)です。モデルの推論処理には膨大な計算が必要となり、CPUだけでは速度が遅すぎて業務利用に耐えられません。GPUは並列計算能力に優れており、特にVRAM(ビデオメモリ)の容量が性能に直結します。例えば7B(70億パラメータ)クラスのモデルであれば12~16GBのVRAMで動作可能ですが、13B以上のモデルでは24GB以上、さらに大規模モデルでは48GB以上が推奨されます。中小企業向けには、NVIDIA RTXシリーズ(RTX 4090やRTX 6000 ADAなど)が現実的な選択肢となります。これらを1基~2基搭載すれば、多くの業務用途に十分対応可能です。

次に、システム全体の構成を考える必要があります。GPUだけでなく、CPU性能やメモリ容量もボトルネックになり得ます。推論時には大量のデータを一時的に扱うため、最低でも64GBのRAMが望ましく、大規模な用途では128GB以上を推奨します。ストレージは、学習データやベクトルデータベースを格納するために高速なNVMe SSDが最適です。容量は2TB以上を確保しておくと安心です。これらをワークステーション型サーバーに組み込めば、中小企業でも十分に自社内でAIを運用できます。

運用設計の観点では、「用途に応じたモデルサイズの選定」が重要です。必ずしも最大規模のモデルが必要とは限らず、社内規程の検索やFAQ対応といった用途であれば、7B~13Bクラスのモデルで十分な性能を発揮します。一方、複雑なレポート生成や多言語対応など高負荷なタスクには、より大きなモデルが必要になる場合もあります。利用目的を明確にし、それに合わせたモデルとハードウェアを選定することで、無駄なコストを抑えられます。

また、冷却と電力の設計も忘れてはなりません。高性能GPUは消費電力が大きく、熱の発生量も多いため、サーバールームの空調や電源設備を見直す必要があるケースもあります。特に中小企業のオフィス環境では、既存の電源容量では不足する場合があるため、導入前に確認することが重要です。さらに、長期運用を前提とするなら、停電や障害に備えたUPS(無停電電源装置)やバックアップシステムも検討する必要があります。

クラウドとの併用も選択肢のひとつです。例えば、平常時はローカルサーバーで運用し、大規模な学習や負荷の高い処理だけをクラウドで行う「ハイブリッド運用」を取り入れることで、コストと柔軟性を両立できます。特にクラウド側で一時的にリソースを借りられる環境を整えておけば、ハードウェアの初期投資を抑えつつ必要な処理をカバーできます。

将来的な拡張性も視野に入れることが重要です。AI活用が軌道に乗れば、利用者数や処理データ量が増加することが見込まれます。初期導入時からスケーラビリティを意識した設計をしておくことで、後々の追加投資を抑えることができます。例えば、GPUを追加搭載できるサーバー筐体を選ぶ、ネットワークを10GbEに対応させておく、ストレージを拡張可能にしておく、といった工夫です。

まとめると、ローカルLLM導入に必要なハードウェアは「GPUを中心とした最適構成」を組むことに尽きます。そして、それを最大限に活かすためには、利用目的に応じたモデルサイズ選定、電力・冷却・拡張性への配慮、クラウドとのバランス設計が不可欠です。当サービスでは、企業の利用シーンに合わせて最適なハードウェア構成を提案し、初期導入から将来拡張まで一貫してサポートいたします。中小・中堅企業が安心してAIを業務に取り入れられるよう、コスト効率と実用性の両立を実現します。

⑥ 導入・運用サポートと導入後の価値最大化

AIを導入する企業の多くが直面する現実は、「導入すればすぐ成果が出るわけではない」という点です。特にローカルLLMのように自社専用のAIを運用する場合、環境構築や学習設計だけでなく、導入後の継続的な運用が成果を左右します。本項目では、導入初期から運用、そして活用効果の最大化までを見据えたサポートのあり方を解説します。

まず、導入初期のステップは「PoC(概念実証)」です。ここでは、大規模な投資を行う前に、小規模なデータセットや限られた業務範囲でAIを試行します。例えば、営業部門で過去のFAQ対応を学習させ、実際にどの程度の精度で回答できるかを確認します。この段階で効果を数値化することで、経営層にとっても導入の判断材料となり、現場にとっても期待感が高まります。当サービスでは、PoCに必要な環境構築やデータ準備を支援し、最短で成果を可視化できる体制を整えています。

次に重要なのが「従業員教育」です。AIがどれほど高性能であっても、利用する社員が適切に使いこなせなければ成果は限定的です。プロンプトの工夫、適切な質問の仕方、AIの回答を検証する姿勢など、基本的なリテラシーを社内に浸透させることが不可欠です。当サービスでは、現場社員向けの操作研修から管理職向けの戦略的活用セミナーまで幅広く提供し、AIが「使える道具」として自然に定着するよう支援します。

導入後に欠かせないのが「効果測定と改善」です。AI導入の目的は、業務効率化、顧客満足度向上、教育コスト削減など多岐にわたりますが、成果を数値で測定しなければ社内での継続的な投資判断が難しくなります。例えば「問い合わせ対応時間の短縮率」「新人教育の習熟スピード」「提案資料作成にかかる工数削減」など、具体的なKPIを設定し、定期的にモニタリングすることが大切です。当サービスでは、導入企業と一緒にKPIを設定し、ダッシュボード形式で成果を可視化する仕組みを提供します。

さらに、AIは「更新され続ける存在」であることを忘れてはいけません。企業の規程や商品情報は常に変化し、放置すればAIの知識はすぐに古くなります。そのため、定期的にデータを更新し、必要に応じてRAGのデータベースを拡張したり、ファインチューニングを追加実施したりすることが不可欠です。当サービスでは、月次や四半期単位でのデータ更新プランを用意し、負担なく継続的にAIを成長させられる体制を整えています。

また、運用負荷を下げるための自動化も重要です。データの収集や整理を自動化し、AIに取り込むフローを作ることで、担当者の負担を軽減できます。例えば、契約書やマニュアルが更新されるたびに自動で学習用フォルダに保存し、AIが参照できるよう同期させる仕組みを導入すれば、常に最新情報を反映できます。これにより、運用チームは「人手で更新作業をする」必要がなくなり、戦略的な活用に専念できます。

成功事例の共有も、導入後の価値最大化に大きな効果を発揮します。他社の事例を学ぶだけでなく、社内での成功体験を横展開することが有効です。例えば、営業部門で成果が出たプロンプト活用法を全社に展開することで、他部門でも同様の効果を得られます。当サービスでは、導入企業の事例をケーススタディ化し、社内研修やマニュアルに活用できる形で提供します。

最後に強調したいのは、AI導入は「一度きりのプロジェクト」ではなく「企業の進化に寄り添うプロセス」であるという点です。中小・中堅企業にとって、AIは業務効率化のツールであると同時に、人材育成や競争力強化の戦略的資産でもあります。導入後も伴走し続けるパートナーがいることで、企業は安心してAIを業務に根付かせ、長期的に成果を高めることができます。

まとめると、AI導入の価値を最大化するためには「初期のPoC」「従業員教育」「効果測定」「継続的更新」「自動化」「成功事例の共有」というサイクルを回すことが不可欠です。当サービスでは、このサイクルを一貫して支援し、AIが企業文化として根付くまで伴走します。これにより、単なるシステム導入を超え、企業の未来を支える基盤としてAIを活用できる環境を実現します。

お問い合わせ

当社のローカルLLM設営・学習支援サービスにご関心をお寄せいただき、誠にありがとうございます。

「自社の規模でも導入できるのか」「小さく始めて効果を見ながら拡張したい」「まずは相談だけしてみたい」など、どのような段階のお悩みでもお気軽にお問い合わせください。当社は特に中小・中堅企業のお客様を対象に、事業規模や業務特性に応じた柔軟な対応を心がけております。小規模なPoCから段階的な拡張、本格的な全社導入まで、お客様の状況に合わせた最適なご提案を行います。専門的な技術課題はもちろん、まだ漠然としたイメージの段階でのご相談にも丁寧にお応えいたします。安心して一歩を踏み出していただけるよう、全力でサポートいたしますので、ぜひお気軽にご連絡ください。